Unité de l’impact et de l’innovation Modèles de mesure des impacts : Guide des méthodes de mesure des impacts

Library and Archives Canada Cataloguing in Publication

©Sa Majesté la Reine du chef du Canada (2019) Tous droits réservés

Toute demande de permission pour reproduire ce document doit être adressée au Bureau du Conseil privé (Unité de l’impact et de l’innovation).

This publication is also available in English:Measuring impact by design - a guide to methods for impact measurement.

CP22-174/2019F-PDF

ISBN: 978-0-660-29541-1

1.0 Message du Bureau du Conseil privé

Nous allons l’honneur de dévoiler la première série de lignes directrices pour la mesure des impacts de l’Unité des impacts et de l’innovation (UII), à l’appui de ses travaux dans le cadre de l’Initiative Impact Canada. Ce document se veut à la fois une introduction accessible à ce sujet ainsi qu’une référence pour les personnes intervenant dans la conception, la mise en oeuvre, l’approvisionnement et les stratégies de mesure des impacts pour les projets d’Impact Canada. Fondé sur des pratiques exemplaires, le document Modèles de mesure des impacts a été rédigé pour amener les lecteurs à repenser la stratégie de mesure des impacts traditionnellement utilisée au sein de la fonction publique fédérale.

Dans son rôle de direction de l’Impact Canada – une initiative pangouvernementale – l'UII travaille avec un réseau en constante expansion de partenaires à l’élaboration d’un programme innovant et axé sur les résultats. Nous sommes conscients que les dépenses associées aux programmes sont des investissements que nous faisons au nom des Canadiens, et directement dans leur intérêt, et que nous devons faire des efforts pour mieux comprendre en quoi ces investissements améliorent la vie des citoyens. Cela signifie que nous devons mieux comprendre ce qui fonctionne, pour qui et dans quel contexte. Nous devons aussi mieux comprendre quels types d’investissements sont susceptibles de maximiser les impacts social, économique et environnemental que nous cherchons.

« Nous sommes conscients que les dépenses associées aux programmes sont des investissements que nous faisons au nom des Canadiens, et directement dans leur intérêt, et que nous devons faire des efforts pour mieux comprendre en quoi ces investissements améliorent la vie des citoyens. »

De bonnes pratiques de mesure des impacts sont fondamentales pour comprendre ces aspects, et nous avons le devoir de faire preuve de rigueur dans nos efforts. Nous reconnaissons que nous devons continuer d’accroître la capacité du gouvernement à miser efficacement sur ces approches. C’est pour cette raison que nous avons assoupli les autorisations relatives à Impact Canada; ainsi les subventions et les contributions peuvent être utilisées pour financer les organismes de recherche qui détiennent une expertise dans le domaine des techniques énoncées dans ce guide. Nous encourageons nos ministères partenaires à envisager de tirer avantage de cette souplesse accrue.

Le guide Modèles de la mesure des impacts est un des nombreux modes de soutien que l’UII fournit pour respecter son engagement d’améliorer les pratiques de mesure des impacts pour Impact Canada. Nous sommes très enthousiastes à l’idée de poursuivre la collaboration avec nos partenaires dans la mise en oeuvre de ces importantes approches axées sur les résultats à l’échelle du secteur public.

Matthew Mendelsohn

Sous-sécretaire du Cabinet,

Résultats et livraison

Rodney Ghali

Secrétaire adjoint du Cabinet,

Unité de l'impact et de l'innovation

2.0 Introduction

Améliorer les résultats pour les Canadiens, c’est la raison d’être d’Impact Canada, une initiative pangouvernementale lancée dans le cadre du budget de 2017 dirigée par l’Unité des impacts et de l’innovation (UII) du Bureau du Conseil privé. L’Initiative Impact Canada accélère l’utilisation d’approches novatrices et expérimentales à l’échelle du gouvernement du Canada. Afin d’atteindre cet objectif central, l’Initiative Impact Canada adopte une approche axée sur les résultats à tous les niveaux. L’importance accordée aux résultats est ce qui relie chacune des fonctions opérationnelles de base de l’Unité des impacts et de l’innovation (UII). Ces fonctions comprennent la mise en oeuvre de nouveaux outils comme l’introspection comportementale dans la conception des programmes, l’utilisation de mesures financières novatrices pour améliorer la mise en oeuvre et l’application de méthodes de pointe pour l’analyse des impacts afin d’évaluer la mesure dans laquelle des résultats ont réellement été obtenus.

Dans le cadre de son mandat de co-conception d’approches novatrices et expérimentales avec les ministères du gouvernement du Canada, l'UII travaille avec ces derniers à la mise en place d’une stratégie d’évaluation rigoureuse pour toutes les initiatives lancées dans le cadre d'Impact Canada par l’intermédiaire d’un processus de planification des projets. À cette fin, ce guide se concentre sur l’utilisation de techniques pour la mesure rigoureuse des impacts qui pourraient s’appliquer à de nombreuses circonstances dans le contexte d'Impact Canada. Le guide Modèles de mesure des impacts est susceptible d’être particulièrement pertinent pour le programme et les efforts de prestation de services qui permettront d’adopter une approche « contrefactuelle » et de comprendre ce qui a été accompli, au-delà de ce qui se serait produit d’une façon ou d’une autre. Dans cette optique, les méthodes décrites dans ce guide peuvent servir à mieux déterminer les impacts causales pouvant être directement attribuées à l’initiative en question. De telles approches, lorsqu’elles sont adéquatement mises en oeuvre, peuvent apporter des preuves plus solides et une plus grande assurance que les résultats observés sont réellement attribuables à l’initiative elle-même plutôt qu’à d’autres facteurs.

Les expériences ou les essais contrôlés randomisés (ECR) ne datent pas d’hier. Les ECR ont commencé à être utilisés au milieu des années 1920 dans le secteur des sciences agricoles, et sont depuis mis à profit par une grande variété d’évaluateurs et de professionnels des sciences sociales dans de nombreux domaines (Jamison, May 2017, p. 15). Ils ont connu une hausse de popularité dans la dernière décennie à mesure que leur utilisation, plus particulièrement dans le domaine du développement international, s’est répandue.

« Un des principaux thèmes de ce document suggère que, moyennant une planification adéquate, la majorité des programmes peuvent miser sur une méthode expérimentale ou quasi expérimentale pour la mesure des impacts qui exige peu ou pas d’ajustements au mode normal de fonctionnement (Gertler, Martinez, Premand, Rawlings, & Vermeersch, 2016, pp. 188-193). »

Les quasi-expériences ont en règle générale des origines plus récentes. Néanmoins, nous pouvons constater qu’elles sont maintenant de plus en plus couramment utilisées en tant que modèles de mesure des impacts. Grâce à ce guide, l'UII espère accélérer leur adoption dans les contextes canadiens. En tant que catégorie de méthodes, les quasi-expériences offrent un équilibre entre rigueur et pragmatisme et, par conséquent, conviennent bien à l’exercice de mesure des impacts. Elles sont assez rigoureuses pour nous fournir des estimations plausibles des impacts, et assez pragmatiques pour être déployées dans des contextes où les méthodes randomisées ne s’appliquent pas. Un des principaux thèmes de ce document suggère que, moyennant une planification adéquate, la majorité des programmes peuvent miser sur une méthode expérimentale ou quasi expérimentale pour la mesure des impacts qui exige peu ou pas d’ajustements au mode normal de fonctionnement (Gertler, Martinez, Premand, Rawlings, & Vermeersch, 2016, pp. 188-193).

2.1 Principaux objectifs

Ce document n’est pas un guide « étape par étape » sur l’application des évaluations expérimentales ou quasi expérimentales. Il se veut plutôt une ressource clé pour aider le personnel chargé des politiques et des programmes à mieux comprendre les principales approches, leurs avantages et leurs désavantages, ainsi que les conditions dans lesquelles elles peuvent être utilisées. Il n’est pas nécessaire que les utilisateurs de ce document possèdent une formation approfondie en méthodes de recherche ou en statistique.

Ce document s’adresse principalement au personnel de première ligne qui supervise l’élaboration et la mise en oeuvre des initiatives d’Impact Canada. Ces employés sont bien placés pour planifier proactivement la mesure des impacts lors de la conception d’un programme. Une planification adéquate à ce stade précoce est un facteur essentiel pour assurer une mesure efficace des impacts. Sans prévisions de ce type, on peut facilement rater d’importantes occasions de saisir des données de base ou de créer des groupes comparables dès les premières étapes d’un programme. Ce genre d’erreur involontaire est très courant et n’est pas facile à gérer. L’UII a établi un processus pour collaborer avec les ministères et les soutenir dans l’élaboration d’une stratégie d’évaluation efficace en tant qu’élément central de la conception du programme. Chaque approche est adaptée aux besoins du ministère ainsi qu’au contexte et aux résultats visés pour chaque initiative.

Le guide est structuré de manière à fournir un aperçu de certains concepts clés liés à la mesure des impacts, de même qu’un aperçu non technique de la principale série de méthodes expérimentales et quasi expérimentales utilisées pour mesurer les impacts. Il vise à en décrire la logique de manière accessible, et il illustre les concepts clés à l’aide d’exemples, lorsque c’est possible.

Voici les principaux objectifs de ce document :

- Approfondir les connaissances des spécialistes des prgrammes et des politiques à l’égard des concepts clés liés à la mesure des impacts;

- Mieux faire connaître les différentes méthodes expérimentales et quasi expérimentales applicables à la mesure des impacts;

- Permettre au personnel de première ligne chargé des programmes et des politiques de promouvoir l’amélioration des évaluations des impacts, plus particulièrement pour les initiatives de financement en fonction des résultats dans le contexte de l’Initiative Impact Canada;

- Offrir une ressource clé au personnel des programmes et des politiques pour lui permettre de se montrer critique à l’égard des stratégies et des rapports de mesure des impacts;

- Faire comprendre quels types de méthodes de mesure des impacts conviennent le mieux au contexte particulier de chaque programme.

2.2 L’Initiative Impact Canada

Annoncée dans le budget de 2017, Impact Canada est un effort pangouvernemental qui aidera les ministères à accélérer l’adoption de méthodes de financement fondées sur les résultats afin de produire des résultats significatifs pour les Canadiens. Les méthodes fondées sur les résultats constituent une nouvelle manière de gérer le financement des subventions et des contributions : il est question de passer de l’approche traditionnelle axée sur le processus et les produits à une approche selon laquelle les paiements sont fonction de l’obtention de résultats mesurables sur les plans économique, environnemental et/ou social.

Impact Canada préconise l’utilisation de différentes méthodes de financement novatrices, notamment les suivantes :

- Défis – L’attribution de prix à celui qui trouve le premier ou le plus efficacement une solution à un problème défini, ou le recours à des concours ouverts et structurés pour solliciter des propositions afin de financer les meilleures idées susceptibles de résoudre des problèmes thématiques.

- Financement en fonction des résultats – Utilisation d’instruments personnalisés afin de privilégier la méthode selon laquelle on verse des fonds aux bénéficiaires de financement en fonction des résultats sociaux positifs et mesurables obtenus (p. ex. obligations à impact social, mécanismes de paiement à la réussite).

- L’application de l’introspection comportementale et d’autres approches fondées sur des preuves pour améliorer la prestation des programmes et des services.

Impact Canada est appuyé par un centre d’expertise situé au sein de UII. L’équipe compte une vaste expérience de l’exécution de programmes nouveaux et novateurs au sein du gouvernement, dans les domaines suivants :

- Approches novatrices du financement et du partenariat – le personnel s’occupe directement de mettre en oeuvre des méthodes de financement novatrices, notamment les obligations à impact social et les investissements à impacts sociales, et de lancer des défis d’externalisation ouverte à grande échelle pour trouver des solutions à des problèmes pressants. Ces expériences nécessitent toutes l’adoption d’approches multisectorielles qui ont permis de rassembler des intervenants venant du gouvernement, du secteur privé et des secteurs philanthropiques et à but non lucratif pour réaliser des résultats communs.

- Mesure des impacts – l’équipe a travaillé avec des partenaires pour concevoir et élaborer conjointement des méthodes fondées sur des données probantes afin d’améliorer les résultats des programmes. Le personnel tire parti d’un ensemble de méthodes d’évaluation et de mesure des impacts, et travaille avec des partenaires à faire avancer de nouvelles méthodes de mesure des impacts.

- Introspection comportementale – l’équipe possède une grande expérience du soutien à la réalisation et à la prestation d’expériences et de projets intégrant les méthodes d’introspection comportementale. Le travail de l’équipe comprend, entre autres, la mise en application de principes et d’approches fondés sur des données probantes, la réalisation d’expériences de petite à grande envergure, et l’application stratégique de la science comportementale à l’élaboration de politiques directement à l’appui du mandat de base et des engagements du gouvernement du Canada.

3.0 Pourquoi mesurer les impacts?

Fondamentalement, la mesure des impacts est une façon impartiale d’orienter les décisions au moyen d’une méthodologie scientifique rigoureuse. La principale raison pour laquelle nous mesurons les impacts d’un programme est que cela nous permet de déterminer si le programme en question a livré ou non les résultats attendus. En outre, lorsqu’elles sont bien conçues, les évaluations des impacts peuvent nous aider à répondre à certaines questions :

- Quels types de programmes sont les plus susceptibles d’apporter de grands avantages à la société?

- Quels types de programmes devrions-nous abandonner ou éviter?

- Comment les avantages d’un programme sont-ils répartis entre les différents groupes sociaux?

- Y a-t-il des volets du programme qui apportent plus d’avantages que d’autres?

- Comment un programme génère-t-il des impacts?

- Comment pouvons-nous améliorer un programme pour accroître ses impacts?

- Quels types de programmes devrions-nous élargir ou mettre à l’échelle?

Dans le contexte plus large de l’innovation dans le secteur public, la pertinence de la mesure des impacts ne fait qu’augmenter :

- La mesure des impacts s’inscrit dans la reddition de comptes, un principe de base pour un bon gouvernement. Nous devons faire preuve de rigueur dans nos efforts pour montrer comment les dépenses publiques sont liées à l’atteinte de meilleurs résultats pour les Canadiens. L’accent accru que nous mettons sur les résultats et livraison au sein du secteur public en est une preuve évidente.

- Les administrateurs généraux sont maintenant tenus d’affecter un pourcentage des dépenses associées aux programmes à l’ expérimentation. La mesure des impacts est une excellente façon de nous aider à respecter cet engagement.

- Les modèles de financement en fonction des résultats, comme les obligations à impact social, sont de nouveaux moyens qu’envisagent les ministères pour améliorer les résultats pour les Canadiens. Ces approches sont des éléments fondamentaux d’Impact Canada. Si nous voulons accorder du financement en fonction des résultats, nous devons pouvoir déterminer clairement quand nous avons obtenu les résultats visés et quand nous n’y sommes pas parvenus. C’est l’objectif central de la mesure des impacts. Il est essentiel d’utiliser une méthode rigoureuse pour évaluer les impacts d’une initiative pour donner aux investisseurs initiaux comme aux investisseurs qui accordent du financement en fonction des résultats confiance que les résultats du programme sont mesurés de façon précise et équitable.

- On observe une demande croissante envers les formes économiques d’évaluation, notamment le rendement social des investissements et l’analyse coûts-avantages. La mesure des impacts est une étape centrale et essentielle de ces approches. Pour évaluer le rendement de l’investissement, nous devons d’abord acquérir une compréhension approfondie des impacts de nos programmes.

- Les décideurs cherchent de plus en plus à innover parce qu’ils veulent découvrir ce qui « fonctionne » lorsqu’ils abordent des problèmes sociaux de longue date ou complexes. Au fil du temps, l’accumulation de plusieurs évaluations des impacts dans des domaines précis pourrait appuyer cet objectif.

Dans l’ensemble, nous travaillons dans un contexte de plus en plus axé sur l’innovation en tant que moyen d’améliorer les résultats pour les Canadiens. Pour cette raison, la mesure des impacts doit être intégrée dans notre façon de travailler.

3.1 Définition de la mesure des impacts

Étant donné que l’atteinte de résultats pour les Canadiens est un élément central d’Impact Canada, comprendre dans quelle mesure les programmes changent la vie des Canadiens revêt une importance majeure. Générer des impacts a une signification précise. Une retombée s’entend de tout changement dans les résultats généré par des investissements dans un programme ou des politiques.

En pratique, les termes « résultats » et « impacts » sont souvent employés de manière interchangeable. Bien qu’ils soient interreliés, ces deux concepts ont chacun une signification qui leur est propre. Un résultat se définit comme tout avantage sur le plan social, environnemental ou économique qu’une politique ou un programme vise à maintenir ou à améliorer d’une quelconque manière. La participation au marché du travail est un bon exemple. La mesure des résultats répond à des questions principalement descriptives, comme : Quel est le taux de participation actuel au marché du travail? En quoi la participation au marché du travail varie-t-elle d’une région à l’autre? A-t-elle changé au fil du temps?

« Les impacts sont définies comme des changements (positifs ou négatifs) dans les résultats sur le plan social, environnemental ou économique qui sont directement attribuables à un investissement.»

Par contraste, une retombée est la mesure dans laquelle un programme produit un changement dans le cadre d’un résultat. Les impacts sont définies comme des changements (positifs ou négatifs) dans les résultats sur le plan social, environnemental ou économique qui sont directement attribuables à un investissement. Pour faire fond sur l’exemple de la participation au marché du travail précédemment cité, les impacts pourraient être évaluées à l’aide de la question suivante : dans quelle mesure un programme de formation professionnelle a-til changé le taux de participation au marché du travail pour les citoyens formés? Dans le cas présent, une règle de base serait de voir les résultats comme un nom, et les impacts comme un verbe.

Il est important de faire une distinction entre résultats et impacts puisque, bien souvent, nous devons nous intéresser à des éléments qui vont au-delà des résultats qui nous intéressent. Souvent, nous voulons déterminer dans quelle mesure nos actions (politiques, programmes ou interventions) mènent à des impacts sur les résultats (des changements aux résultats). Voilà le rôle de la mesure des impacts. Par conséquent, la mesure des impacts va plus loin que la mesure des résultats, et permet d’établir à quel point une politique ou un programme influe sur les résultats d’intérêt. Autrement dit, c’est une façon d’isoler la mesure dans laquelle un programme change les résultats des effets de tout autre élément susceptible d’avoir également changé les résultats.

À partir de cette définition, les sections suivantes fourniront un aperçu de certains concepts clés liés aux impacts; nous passerons ensuite à une description des principales méthodes de mesure des impacts que nous devrions connaître.

3.2 Problèmes associés à la mesure des impacts

Lorsqu’il s’agit de mesurer les impacts d’un programme, il devient rapidement clair que nous devons surmonter un problème : il n’est pas toujours évident que les résultats que nous observons sont bel et bien le produit des interventions qui nous intéressent.

Imaginons qu’un groupe d’individus participent à un programme visant à accroître leur niveau d’activité physique. Après trois mois, nous observons qu’ils sont (en moyenne) plus actifs qu’ils l’étaient avant de participer au programme. Le programme a-t-il été efficace? Dans ce scénario, il est impossible de dire si c’est le programme lui-même qui a amené un changement dans les résultats ou si ce changement était en tout ou en partie attribuable à d’autres facteurs.

- Supposons que le programme a commencé en avril et s’est terminé en juin. Il est possible que les participants soient simplement devenus plus actifs avec le retour du beau temps.

- Supposons qu’une autre organisation a offert un programme différent à ce même groupe d’individus. Il est également possible que ce soit ce programme qui ait amené les impacts voulues, et que notre programme n’en ait amené aucune – ou ait même eu des impacts négatives.

- Supposons qu’une étude majeure sur les bienfaits d’un style de vie sain ait été publiée au même moment. Nous ne pouvons pas nécessairement isoler les effets du programme des effets de cette nouvelle information que nos participants pourraient avoir reçue.

Version texte - Figure 1

Un organigramme illustre la différence entre l’état des résultats et l’état hypothétique. L’état préalable à l’intervention est représenté sous la forme d’un rectangle, qui passe par une ligne continue à travers une intervention (représentée sous la forme d’un losange), jusqu’à un état de résultat. L’état hypothétique, qui se serait produit en l’absence d’une intervention, est représenté sous la forme d’un rectangle plus clair, relié directement à l’état antérieur à l’intervention par une ligne en pointillé.

Cet exemple illustre très bien pourquoi il est essentiel de faire une distinction entre les résultats et les impacts. Les résultats changent souvent, et souvent pour des raisons que nous ne connaissons pas nécessairement. Si nous voulons comprendre les impacts d’un programme en particulier, mesurer des résultats changeants ne suffit pas. Cette stratégie ne nous permettra pas d’attribuer ce changement à une cause unique, comme un programme. Nous devons trouver une façon de comparer ce qui s’est produit avec ce qui se serait produit. C’est ce que nous appelons des scénarios factuels et contrefactuels. Le scénario factuel est ce qui s’est réellement produit (participation au programme). Le scénario contrefactuel est ce qui se serait produit en l’absence du programme. Par définition, le scénario contrefactuel ne peut jamais être observé parce qu’il représente ce qui ne s’est pas produit. Donc, la difficulté qui réside dans la mesure des impacts est de trouver une façon de reconstruire ce qui se serait produit en l’absence d’un programme, ce qui nous permet de comparer ces deux scénarios et d’évaluer les véritables impacts.

« Le scénario factuel est ce qui s’est réellement produit (participation au programme). Le scénario contrefactuel est ce qui se serait produit en l’absence du programme. »

Mesurer les impacts est ce qui nous permet d’isoler les effets d’un programme sur un résultat (ou des résultats) d’intérêt. C’est comme si on se demandait : dans quelle le mesure le changement observé dans les résultats est-il attribuable au programme lui-même? Comme nous le verrons plus loin dans ce document, la meilleure approche à adopter consiste à comparer deux groupes similaires en tous points, sauf qu’un groupe participe au programme, l’autre non. Nous appellerons le premier groupe de traitement ou groupe test, et le second, groupe témoin ou groupe de comparaison. Étant donné que la seule chose qui distingue ces deux groupes est leur participation à un programme, toute différence observée dans les résultats obtenus par chacun d’eux peut être attribuée à cette intervention, et seulement à celle-ci. C’est ce qui nous démontre que le programme a des impacts. Les sections subséquentes de ce document fourniront une introduction aux principales méthodes utilisées pour mesurer les effets d’un programme ou d’une politique afin d’en déterminer les véritables impacts.

3.3 Le principe ceteris paribus

En latin, ceterus paribus signigie « toutes choses demeurant égaless »..

Pour pouvoir comprendre les résultats contrefactuels, il faut comparer les résultats d’un groupe de traitement avec ceux d’un groupe témoin. Pour ce faire, nous devons nous assurer que le groupe témoin respecte ce qu’on appelle le principe ceteris paribus. En latin, ceteris paribus signifie « toutes choses demeurant égales ». En répartissant des individus de façon aléatoire dans deux groupes, ou en créant des groupes correspondants où nous nous assurons que les participants présentent les mêmes variables clés, nous minimisons la probabilité que des différences systématiques existent entre les deux groupes, ce qui nous permet de tenir pour acquis que tout élément pouvant affecter les résultats a la même influence sur les deux groupes. Ainsi, lorsqu’un de ces deux groupes ne participe pas à l’intervention, les résultats obtenus par ce groupe représentent les résultats qu’aurait obtenus le groupe de traitement en l’absence de l’intervention. En outre, le principe ceteris paribus nous permet de nous assurer que les groupes réagiraient de la même façon à une intervention.

Gertler et coll. (2016, p.52) mentionnent trois critères qu’il convient de considérer au moment d’évaluer si le groupe de traitement et le groupe témoin respectent le principe ceteris paribus :

- Il devrait y avoir un équilibre entre les deux groupes en ce qui concerne les caractéristiques moyennes, autant les caractéristiques observables (âge, sexe, etc.) que les caractéristiques non observables (motivation, capacités, etc.);

- Le traitement (programme ou politique) ne peut en aucun cas affecter directement ou indirectement le groupe de comparaison (par exemple, les membres du groupe de comparaison ne peuvent pas recevoir le traitement);

- Les résultats du groupe de comparaison devraient changer de la même façon que ceux du groupe de traitement si le groupe de comparaison était exposé au programme.

Version texte - Figure 2

Une image illustre comment les groupes témoins permettent aux évaluateurs de déterminer l’effet d’un traitement. Un test et un groupe témoin sont représentés chacun par des rectangles. Les deux sont exposés à deux influences (A et B), qui sont chacune représentées par des flèches moyennement ombragées descendant vers chaque rectangle. Tant pour le groupe d’essai que pour le groupe témoin, ces influences produisent trois unités de résultats, qui sont représentées par des carrés moyennement ombragés. Le groupe d’essai est également exposé à une intervention, qui est représentée par une flèche ombragée foncée, ce qui a pour effet de produire trois résultats supplémentaires pour le groupe d’essai, représenté par trois carrés ombragés foncés. L’effet de l’intervention est donc représenté visuellement par la différence de nombre de résultats entre le groupe expérimental et le groupe témoin.Lorsque ces critères sont satisfaits, nous pouvons établir que les deux groupes respectent le principe ceteris paribus, c’est-à-dire les deux groupes sont similaires en tous points avant le traitement, sauf qu’un groupe participe au programme, l’autre non. Il s’agit donc d’un groupe témoin valide. Cela nous permet d’attribuer la différence entre les résultats des deux groupes au programme lui-même puisqu’aucun autre élément ne les distingue.

3.4 Validité interne et externe

Deux aspects clés de la mesure des impacts doivent être pris en compte dans toute évaluation :

- La validité interne, c’est-à-dire la mesure dans laquelle une évaluation permet d’établir efficacement le lien de cause à effet d’une intervention sur les résultats d’intérêt.

- La validité externe, c’est-à-dire la mesure dans laquelle les impacts estimées d’une étude peuvent être généralisées pour inclure, par exemple, d’autres régions, groupes de population, etc.

Il est essentiel de comprendre que la validité interne et la validité externe sont des concepts indépendants, et qu’une étude peut avoir une validité interne élevée et une validité externe faible, et vice-versa. Ce guide se concentre principalement sur l’établissement de la validité interne. Une section subséquente est consacrée aux questions liées à la validité externe.

3.5 Principales menaces pour la validité interne d’une évaluation des impacts

Lorsque le principe ceteris paribus est respecté, nous pouvons comparer les résultats de notre groupe de traitement et de notre groupe de comparaison, et établir une estimation non biaisée des effets 1 du traitement. Cela revient exactement à dire que les résultats ont une validité interne élevée. Dans le cas des évaluations des impacts qui ne se fondent pas sur des groupes de comparaison valides, certains biais ou certaines menaces pourraient nuire à la validité interne (Campbell, 1957). Les causes les plus fréquentes et les plus importantes de biais sont :

- Biais de sélection;

- Causalité inverse;

- Erreur de mesure systématique;

- Effets du temps;

- Non-conformité;

- Effet placebo;

- Effets comportementaux;

- Biais de l’observateur.

Le but de la mesure des impacts est de choisir un modèle qui élimine, ou du moins réduit au minimum, les sources potentielles de biais. Lorsque les sources de biais ne sont pas adéquatement gérées, la validité interne d’une évaluation des impacts peut être compromise, et les résultats doivent être interprétés avec précaution.

Biais de sélection

Les biais de sélection surviennent lorsque des différences systématiques existent entre les caractéristiques (observables ou non observables) du groupe de traitement et du groupe témoin à cause du processus de répartition des individus dans les deux groupes. Par exemple, cela peut se produire dans un programme de formation professionnelle lorsqu’un plus grand nombre d’individus motivés s’inscrivent au programme ou que les administrateurs du programme sélectionnent les participants qui ont de meilleures capacités. Dans ce cas, le groupe de traitement serait fondamentalement différent du groupe témoin avant même le début du programme de formation professionnelle – plus particulièrement, le groupe de traitement serait plus motivé ou aurait de meilleures capacités que le groupe témoin en raison du processus de sélection. Cela signifie souvent qu’au fil du temps, le groupe de traitement obtiendra naturellement de meilleurs résultats que le groupe témoin, peu importe l’efficacité de la formation professionnelle. Il se pourrait fort bien que dans ce scénario, la comparaison des résultats du groupe de traitement et du groupe témoin mène à une surestimation des impacts du programme de formation professionnelle. Lorsque le biais de sélection est problématique, le groupe témoin n’est pas valide et on tient pour acquis que l’estimation des effets du traitement (toute différence dans les résultats) est biaisée.

La raison pour laquelle nous devons nous attarder aux caractéristiques du groupe de traitement et du groupe témoin est que certaines de ces caractéristiques sont très susceptibles d’avoir une incidence sur des résultats d’intérêt qui sont indépendants du programme évalué. Les biais de sélection sont malheureusement très courants dans les études d’évaluation. Pour les programmes auxquels les participants peuvent s’inscrivent de leur propre gré, il pourrait y avoir présence d’un biais de sélection puisque les individus qui choisissent d’y participer sont nécessairement différents de ceux qui choisissent de ne pas y participer. Même si cela peut être attribué au hasard dans certains cas, en pratique, nous ne pouvons jamais tenir pour acquis que ces raisons n’influencent pas les résultats.

Les biais de sélection peuvent entraîner une surestimation, ou une sous-estimation des impacts :

- Il arrive couramment que les individus les plus susceptibles de réussir sont ceux qui s’inscriront de leur propre gré ou qui seront sélectionnés par les administrateurs du programme. Dans ces cas, on tient généralement pour acquis que la simple comparaison des résultats observés entre le groupe de traitement et le groupe témoin mènera à une surestimation des impacts.

- Dans d’autres cas, les administrateurs du programme pourraient intentionnellement choisir des individus qui ont moins de chances de réussir (p. ex., parce qu’ils ont moins de capacités ou de motivation); une simple comparaison des résultats observés entre le groupe de traitement et le groupe témoin mènera alors à une sous-estimation des impacts.

Le problème lorsqu’on tente de gérer un biais de sélection, c’est que même si de nombreux facteurs/caractéristiques sont observables (p. ex., sexe, âge, situation d’emploi, revenu, éducation, état de santé), de nombreux facteurs/caractéristiques ne le sont pas. En pratique, les caractéristiques observables sont faciles à gérer dans les évaluations des impacts. Nous pouvons comparer ces types de caractéristiques entre nos deux groupes et, si certaines caractéristiques sont différentes, nous saurons alors que ces deux groupes ne sont pas comparables.

« Les biasis de sélection surviennent lorsque des différences systématiques existent entre les caractéristiques (observables ou non observables) du groupe de traitement et du group témoin à cause du processus de répartition des individus dans les deux groupes. »

Les caractéristiques non observables sont les plus difficiles à gérer, et elles peuvent prendre deux formes. La première forme comprend les éléments difficiles ou carrément impossibles à observer. Des éléments comme les traits de personnalité, le degré de motivation, les habiletés/capacités intellectuelles et les préférences sont généralement non observables, ou du moins très difficiles à mesurer avec précision. La deuxième forme de caractéristique non observable comprend les caractéristiques qui pourraient en fait être observables, mais qui (pour une quelconque raison) ne figurent pas dans les données disponibles. Par exemple, certains éléments considérés comme délicats pourraient ne pas avoir été pris en compte, comme le revenu ou l’orientation sexuelle.

Effets du temps

Les effets du temps (aussi appelés « effets historiques ») sont un enjeu majeur qui peut compromettre la validité des comparaisons simples avant-après des résultats. Ils représentent en partie ce qui se serait produit en l’absence d’une intervention, ce qui signifie qu’ils ne constituent pas une retombée des interventions dont nous voulons mesurer les impacts. Chaque fois que nous mesurons un résultat avant une intervention et ce même résultat après une intervention, nous devons considérer que de nombreux éléments peuvent changer au fil du temps dans le contexte global, et qu’un grand nombre de ces éléments peuvent influencer les résultats de façon indépendante du programme. Notre exemple précédent dans lequel un programme d’activité physique se déroule pendant l’été illustre bien le problème que peuvent représenter les effets du temps. Il se peut fort bien que les niveaux d’activité physique fluctuent naturellement avec les changements de saison. Nous devons faire très attention de ne pas attribuer ces changements naturels dans les résultats aux programmes que nous évaluons puisque nous pouvons ainsi facilement surestimer ou sous-estimer les véritables effets du programme.

Dans ces cas, disposer d’un groupe témoin permet d’utiliser des modèles capables d’isoler les effets du temps des effets de l’intervention, à l’aide des techniques décrites plus loin dans ce document. Comme précédemment mentionné, le groupe témoin doit être similaire au groupe de traitement, auquel cas les impacts des effets du temps seront les mêmes au sein du groupe de traitement que du groupe témoin et seront ainsi contrôlées dans le cadre de l’étude.

Toute autre source de biais connexe est ce qu’on appelle la régression vers la moyenne. La régression vers la moyenne est un phénomène où les résultats « extrêmes » (anormalement élevés ou anormalement faibles) se rapprochent naturellement de la valeur moyenne de ces résultats au fil du temps. Prenons pour exemple un programme de tutorat pour les étudiants qui ont des difficultés d’apprentissage. Leurs résultats (dans ce cas-ci, leurs notes) auront tendance à s’améliorer naturellement, simplement parce qu’ils ne peuvent pas vraiment empirer (ils ne peuvent que s’améliorer d’une façon ou d’une autre). Dans ces cas, nous pourrions avoir tendance à surestimer les impacts du programme de tutorat puisqu’il est fort probable que les notes augmenteraient naturellement (dans une certaine mesure) en l’absence de ce programme.

Causalité inverse

En ce qui concerne le problème de sélection précédemment mentionné, les estimations peuvent être extrêmement biaisées et le seront si la population ciblée par l’intervention a été choisie (ou si les personnes s’inscrivent de leur propre gré) en fonction des résultats qu’on souhaite obtenir à la suite de l’intervention. Par exemple, si un service de police déploie une unité de forces spéciales dans les régions où le taux de criminalité est le plus élevé, une simple comparaison du taux de criminalité entre les régions de traitement et les régions témoins révélera que l’intervention est associée avec des taux de criminalité élevés plutôt que faibles. Une présence policière accrue pourrait générer une augmentation du taux de signalement des crimes, ce qui pourrait donner l’impression que l’intervention (présence policière) exacerbe le problème (crime), même si elle a en réalité l’effet opposé. De façon similaire, si une intervention touchant la santé, comme un programme d’exercice, a tendance à attirer avant tout des gens plus sportifs et en meilleure santé, cela mènera à une estimation biaisée des impacts.

Dans ces cas, ce sont les résultats escomptés qui donnent lieu à l’intervention, et non le contraire. Il peut être utile de voir la causalité inverse comme un scénario de type « la poule ou l’oeuf ». Il ne faudrait pas considérer cela comme un simple effet de causalité. Dans de tels cas, les données longitudinales portant sur les résultats au fil du temps permettent d’utiliser des techniques qui donnent une meilleure estimation de l’effet de causalité.

Erreur de mesure systématique

Les erreurs de mesure renvoient aux écarts qui existent entre les valeurs réelles et les valeurs enregistrées d’une mesure. Ces différences peuvent être aléatoires ou non aléatoires/systématiques. Par exemple, les individus ont souvent tendance à gonfler leur revenu, ce qui signifie que la valeur enregistrée de leur revenu est supérieure à leur revenu réel.

« Les erreurs de mesure renvoient aux écarts qui existent entre les valeurs réelles et les valeurs enregistrées d’une mesure. Ces différences peuvent être aléatoires ou non aléatoires/systématiques. »

Une erreur de mesure aléatoire ne pose pas de problème étant donné que les erreurs surviennent de façon aléatoire à la fois pour les sujets tests et les sujets de comparaison, et que ces anomalies mèneront en théorie à un équilibre entre les deux groupes. Ce sont plutôt les erreurs de mesure systématiques qui représentent un problème.

Non-conformité

Certains participants pourraient ne pas se conformer au groupe dans lequel ils ont été répartis. Par exemple, des participants du groupe de traitement pourraient refuser de suivre le programme ou abandonner le programme avant la fin (on appelle ce phénomène attrition), tout comme des participants du groupe témoin pourraient trouver une façon de retirer des bienfaits du traitement. La probabilité d’une non-conformité dépend grandement de la nature de l’intervention et de la mesure dans laquelle le comportement des participants est facile à surveiller. Une intervention où il faut visionner une vidéo de 20 minutes sur la santé et la sécurité dans une salle de cours est susceptible de générer un taux de conformité élevé. Or, dans le cadre d’une autre intervention où la même vidéo est envoyée par courriel aux participants, le taux de conformité pourrait être plus faible. Et si l’intervention exige une participation à un programme de formation de six mois, l’attrition pourrait devenir un problème.

« Malheureusement, la non-conformité est rarement aléatoire, et des données probantes de nombreux secteurs tels que la formation professionnelle, la formation sur l’abus d’alcool ou d’autres drogues et la psychothérapie appuient ce fait (Shadish, Cook, & Campbell, 2002, pp. 323-324). »

La non-conformité n’influence pas l’estimation des effets du traitement si elle est aléatoire. Malheureusement, la non-conformité est rarement aléatoire, et des données probantes de nombreux secteurs tels que la formation professionnelle, la formation sur l’abus d’alcool ou d’autres drogues et la psychothérapie appuient ce fait (Shadish, Cook, & Campbell, 2002, pp. 323-324). Par exemple, les gens moins motivés ou qui ont des problèmes de santé sont plus susceptibles d’abandonner un programme de formation professionnelle. Ces cas de non-conformité non aléatoire représentent un problème parce qu’ils altèrent systématiquement la composition du groupe de traitement ou du groupe témoin, ce qui signifie qu’ils ne sont plus similaires (comparables). Dans ce cas, l’estimation des impacts est susceptible d’exagérer les véritables effets puisque les individus qui demeurent dans le groupe de traitement sont, en moyenne, plus motivés et en meilleure santé que ceux du groupe témoin en raison de l’attrition.

Il est généralement impossible d’obtenir une conformité parfaite, autant pour des raisons éthiques (il est souvent impossible d’imposer une intervention de force à quelqu’un sans son consentement) que pratiques (cela exigerait de surveiller constamment un grand nombre d’individus sur une longue période), ou encore pour des raisons inévitables telles que le décès de participants. Une façon de contourner cette difficulté consiste à utiliser un modèle d’encouragement, décrit plus loin dans ce document.

Effet placebo

L’effet placebo découle de l’expérience de recevoir le traitement plutôt que du traitement lui-même. On l’observe souvent dans le domaine de la santé, où c’est un fait bien connu que les patients peuvent réagir à des comprimés de sucre lorsqu’ils croient qu’il s’agit d’un véritable médicament. Cet effet est habituellement contrôlé à l’aide d’une technique appelée « essai à insu », où les participants ne peuvent pas savoir s’ils ont été placés dans le groupe de traitement ou le groupe témoin, généralement parce que les deux groupes reçoivent une forme de traitement (p. ex., un véritable médicament ou un comprimé de sucre identique au médicament).

« L’effet placebo découle de l’expérience de recevoir le traitement plutôt que du traitement lui-même. »

L’effet placebo est souvent difficile à gérer dans les programmes sociaux puisqu’il nécessite l’administration de traitements fictifs ou placebo. Dans l’exemple du programme de formation professionnelle, cela supposerait en fait de faire participer le groupe de contrôle à un programme placebo soigneusement élaboré. Une solution serait de procéder à un essai à volets multiples, dans lequel le groupe de traitement et le groupe témoin reçoivent le traitement, mais où le groupe de traitement reçoit un soutien supplémentaire. Toutefois, il convient de noter que les impacts estimées renvoient aux impacts des options du programme plutôt qu’au programme lui-même. Dans les cas où un programme est modifié d’une quelconque façon, une autre approche à adopter serait d’utiliser le programme original comme référence pour le programme modifié, ce qui permettrait de comparer la nouvelle approche avec le statu quo.

Il faut aussi mentionner que dans certains cadres politiques, les effets placebo font souvent partie des effets souhaités et il n’est pas nécessaire d’en tenir compte. Par exemple, un programme de formation pourrait améliorer le rendement des participants, soit en leur permettant d’acquérir de nouvelles compétences grâce au contenu du cours, soit en augmentant leur motivation par le simple fait qu’ils participent au programme. Les deux cas représenteraient toutefois un résultat souhaité.

Effets comportementaux

Dans le même ordre d’idées que l’effet placebo, le changement de comportement de certains participants au cours d’une évaluation des impacts pose problème. On peut observer ce genre de changement quand certaines personnes savent qu’elles font partie du groupe de traitement ou du groupe témoin lorsqu’aucun placebo n’est utilisé. Les deux principaux effets comportementaux sont les suivants :

- Effet Hawthorne : Les participants au programme modifient leur comportement parce qu’ils sont observés. Ce nom provient d’une étude réalisée à Hawthorne Works, une usine électrique située dans l’État de l’Illinois. Dans le cadre de cette étude, une augmentation du rendement des travailleurs au départ attribuée à un meilleur éclairage et à une plus grande propreté des postes de travail a par la suite été attribuée au fait que les sujets savaient qu’ils participaient à une étude et qu’ils portaient plus attention à leur travail pour cette raison. En résumé, le groupe de traitement peut obtenir de meilleurs résultats même si le programme n’a aucun effet et, par conséquent, l’effet Hawthorne mène à une surestimation biaisée des impacts.

- Effet John Henry : les membres du groupe de comparaison (non-participants) modifient leur comportement lorsqu’ils savent qu’ils ne reçoivent pas le traitement. Par dépit, les membres du groupe de comparaison pourraient être motivés à en faire plus que d’habitude pour améliorer leurs résultats afin de montrer aux administrateurs du programme qu’ils peuvent s’améliorer sans l’aide du programme. Dans ce cas, les résultats du groupe témoin peuvent s’améliorer et l’effet John Henry mène à une sous-estimation biaisée des impacts.

Comme pour l’effet placebo, il est recommandé, dans la mesure du possible, de mener des essais à l’insu des sujets, qui ne savent pas à quel groupe ils appartiennent et sont soumis à des conditions égales (les deux groupes sont surveillés avec le même degré d’attention), afin d’éviter les effets comportementaux tels que l’effet Hawthorne et l’effet John Henry.

Dans le domaine des sciences médicales, la pratique exemplaire consiste à utiliser un protocole à double insu. Dans ce cas, le groupe de traitement et le groupe témoin, ainsi que les administrateurs du programme (ceux qui distribuent les comprimés), ne savent pas quels comprimés (véritable médicament ou placebo) ils prennent ou distribuent. Les essais à insu dans le domaine des sciences sociales sont généralement beaucoup plus difficiles à réaliser – par exemple, même dans le cas d’un programme de formation professionnelle fictif ou placebo pour un groupe témoin, les administrateurs du programme sauront quel programme ils donnent, ce qui pourrait fournir des indices aux participants du groupe de comparaison. En réalité, ces types de placebos sont exigeants sur le plan des ressources et ne sont généralement pas pratiques.

Biais de l’observateur

L’évaluateur (observateur) pourrait consciemment ou inconsciemment s’attendre à différents résultats de la part des sujets traités et des sujets non traités. Cela pourrait mener à une évaluation biaisée de la part de l’évaluateur au moment de consigner les mesures (plus particulièrement, si l’évaluation est subjective, l’évaluateur pourrait juger instinctivement que le groupe traité a mieux réussi parce qu’il/elle sait que le groupe était traité), ou encore l’évaluateur pourrait envoyer différents signaux/indices aux sujets des deux groupes, ce qui pourrait influencer leur comportement. Lorsque les biais de l’observateur peuvent s’avérer problématiques, la solution typique consiste à mener un essai à double insu, où ni les participants ni les responsables de la saisie des données ne savent qui fait partie du groupe de traitement et du groupe de comparaison. L’affectation des participants à l’un ou l’autre des groupes est déterminée par un tiers qui ne connaît pas les caractéristiques des participants.

4.0 Matrice de preuves d’Impact Canada

La hiérarchie des preuves (ou pyramide des preuves) est un principe qui a gagné en popularité au cours des dernières décennies. Cette hiérarchie classe les méthodes de mesure des impacts en fonction de leur validité interne. Les essais contrôlés randomisés (ECR) occupent généralement le sommet du classement, suivis des méthodes quasi expérimentales et des modèles de base (avant-après). Cette approche a beaucoup de mérite, bien qu’elle puisse entraîner une perception erronée que les ECRs représentent une méthode « de haut calibre » universelle. Cela peut réduire le recours à d’autres méthodes rigoureuses qui pourraient s’avérer plus appropriées dans certains contextes. En outre, les ECR ne sont pas toujours réalisables sur le plan administratif. Les programmes de subventions et de contributions, par exemple, ne financent pas toujours les ECR étant donné qu’on considère qu’il y a chevauchement avec les sources de financement de la recherche.

Bien que la validité interne soit de toute évidence le principal critère pris en compte pour le choix de la méthode de mesure des impacts, d’autres préoccupations sont également pertinentes :

- Éthique : Dans de nombreux cas, la répartition aléatoire pourrait être (ou être perçue comme étant) contraire à l’éthique, tout comme le fait de refuser des services à un groupe afin de créer un groupe de comparaison. De nombreux fournisseurs de services travaillent avec des ressources limitées et ciblent délibérément les individus qui ont les plus grands besoins. En revanche, il peut être contraire à l’éthique d’attribuer certains éléments de façon aléatoire. Par exemple, fumer cause le cancer, mais aucune étude expérimentale ne le démontre puisqu’il est contraire à l’éthique d’attribuer du tabac de façon aléatoire.

- Faisabilité : Nous pouvons nous intéresser aux impacts de nombreux éléments sur les résultats, sans toutefois pouvoir les attribuer de façon aléatoire. Le sexe ou les traits de personnalité en sont de bons exemples. Nous ne pouvons pas manipuler ces éléments, donc nous ne pouvons pas les attribuer de façon aléatoire.

- Impossibilité d’exclure : Certains types de programmes ou d’interventions se déroulent dans un contexte où il est impossible de créer un groupe de contrôle puisque tous les participants sont simultanément exposés à l’intervention. La législation, la réglementation et l’imposition en sont de bons exemples. Nous ne pouvons pas étudier les impacts de la légalisation du cannabis sur les Canadiens à l’aide d’un essai contrôlé randomisé puisque la loi s’applique de façon universelle à tous les Canadiens – il n’y a pas de groupe de contrôle.

Texte version - Figure 3

La matrice des données probantes décrit l’ensemble principal de la méthode de mesure de l’effet, organisée sous forme de grille. Les essais contrôlés randomisés occupent une position centrale dans la case ombragée la plus foncée, tandis que les méthodes plus fortes (variables instrumentales et discontinuité de la régression) sont placées dans la rangée supérieure dans une teinte moyenne, au-dessus des méthodes plus faibles dans la teinte la plus claire, qui comprennent l’écart dans les différences, les appariements, les séries chronologiques interrompues, les variables non équivalentes et les études de contrôle de cas.

Il n’est pas logique de laisser entendre qu’une « norme absolue » s’applique dans tous les cas. Dans les cas où il est possible d’établir des groupes témoins, les approches randomisées seront généralement les méthodes les plus efficaces étant donné qu’elles comportent le plus haut degré de validité interne.

« Pour Impact Canada, notre approche consiste à nous efforcer d’utiliser la méthode (validité interne) la plus rigoureuse possible étant donné les réalités opérationnelles du programme dont nous mesurons les impacts. »

Il est toutefois impossible de répondre à certaines questions sur les impacts à l’aide de la randomisation, c’est pourquoi les méthodes non randomisées (quasi-expériences), même si leur degré de validité interne est moins élevé, sont souvent notre meilleur choix. Pour Impact Canada, notre approche consiste à nous efforcer d’utiliser la méthode (validité interne) la plus rigoureuse possible étant donné les réalités opérationnelles du programme dont nous mesurons les impacts. Cela suppose d’utiliser des techniques expérimentales et quasi expérimentales, selon les besoins.

Au lieu d’une pyramide ou d’une hiérarchie traditionnelle, l’UII utilise une matrice de preuves qui présente un menu des options possibles pour mesurer les impacts et qui illustre trois principes clés :

- L’absence d’une hiérarchie claire indique qu’aucune méthode n’est universellement applicable à tous les cas.

- Cela étant dit, les méthodes randomisées, notamment les ECR, les études par étapes/avec liste d’attente et les plans multifactoriels, occupent une place unique dans le menu des options en tant que catégorie de méthodes présentant le plus haut degré de validité interne.

- L’efficacité d’une méthode sur le plan de la validité interne est généralement indiquée sur une échelle de couleurs, où les couleurs plus foncées indiquent une validité interne plus élevée.

Le classement des différentes méthodes de mesure des impacts repose sur le principe clé selon lequel la rigueur s’observe dans la mise en oeuvre plutôt que dans le nom. Un schéma d’appariement bien exécuté pourrait très bien s’avérer plus efficace qu’un modèle de discontinuité de la régression mal exécuté, c’est pourquoi il faut faire preuve de vigilance en ce qui concerne la qualité. Étant donné que ces méthodes peuvent être difficiles à concevoir et à mettre en oeuvre, l’UII encourage la collaboration, dans la mesure du possible, avec des experts qui fourniront conseils et orientation pour qu’on puisse assurer l’exactitude des méthodes d’évaluation des impacts et des conclusions qui en découlent.

4.1 Choisir le bon modèle

Selon le principe de causalité et la définition de la mesure des impacts décrits dans le présent document, nous avons classifié les méthodes décrites ci-après dans l’Échelle des preuves d’Impact Canada. Cette échelle classe les différentes méthodes par ordre d’efficacité au chapitre de la validité interne (c.-à-d. capacité à fournir des estimations rigoureuses des impacts). Comme nous l’avons vu précédemment, il convient de noter que ce classement ne tient pas compte des problèmes associés à la validité externe (c.-à-d. généralisabilité des résultats de l’étude). Cet aspect est abordé à la fin du présent guide.

Pour que le classement soit plus facile à visualiser et à comprendre, nous avons réparti les méthodes dans six niveaux de validité distincts. Pour chaque niveau de l’échelle, une liste des méthodes associées à la catégorie en question est fournie. Veuillez noter que certaines méthodes comportent plusieurs variantes (p. ex., les méthodes d’appariement peuvent être combinées avec la méthode « écart entre les différences »), mais elles sont classées au même niveau que la méthode à laquelle elles sont associées.

Conformément à une pratique exemplaire dans ce domaine (qui se fonde sur les seuils de preuve généralement acceptés par de nombreux gouvernements et organisations du secteur public dans les pays de l’ OCDE ), nous établissons le seuil minimal au niveau 4. L’utilisation de méthodes de niveau 5 et de niveau 6 n’est pas recommandée pour la mesure des impacts étant donné que ces méthodes ne satisfont pas à une norme fondamentale pour la mesure des impacts, à savoir une validité interne élevée. En règle générale, il convient de privilégier des méthodes de niveau aussi élevé que possible dans le classement, mais les ressources utilisées pour l’évaluation doivent être proportionnelles à la portée du programme évalué.

Au moment d’utiliser l’Échelle des preuves d’Impact Canada, il est important de ne pas oublier que la rigueur réside dans la mise en oeuvre de la méthode plutôt que dans son nom. La rigueur d’une méthode est fonction de certaines prémisses. Certaines des méthodes les plus complexes, tout particulièrement les évaluations à l’aide de variables instrumentales, peuvent être très instables, et toute estimation établie à partir d’un instrument non valide ou inefficace peut générer d’importants biais et s’avérer considérablement moins efficace qu’une évaluation à l’aide d’une méthode de niveau 1.

« Au moment d’utiliser l’Échelle des preuves d’Impact Canada, il est important de ne pas oublier que la rigueur réside dans la mise en oeuvre de la méthode plutôt que dans son nom. »

Un dernier point qui doit être mentionné ici est que le niveau associé à la méthode n’est d’aucune façon lié au niveau d’efforts ou de ressources requis pour mener l’étude, donc le budget ne devrait pas être pris en compte au moment de déterminer l’étude à réaliser. Par exemple, une étude de l’écart entre les différences ou une étude cas-témoins peut exiger plus de temps et d’argent qu’une expérience, qui exige une bonne planification, mais moins d’analyse statistique qu’une étude des écarts entre les différences ou une étude cas-témoins.

Les sections suivantes présentent les principales caractéristiques de chaque méthode de mesure des impacts, traitent des différents contextes dans lesquels ces méthodes sont susceptibles d’être le plus efficaces et abordent certains éléments clés à considérer pour mesurer la qualité des évaluations des impacts réalisées à l’aide de ces méthodes. Ces sections sont suivies d’une brève section traitant des avantages uniques des méthodes qualitatives utilisées pour mesurer les impacts.

-

4.2 Échelle des preuves d’Impact Canada

Niveau Description Méthode 1 L’intervention est menée de façon aléatoire ou « considérée comme étant menée de façon aléatoire » dans le cadre de processus naturels, notamment lorsque le groupe de traitement et le groupe témoin présentent des caractéristiques de base en moyenne identiques au chapitre des variables observables et non observables. Cela signifie que les groupes sont identiques (en expectation) et obtiendraient les mêmes résultats en l’absence de l’intervention. Par conséquent, tout écart dans les résultats observés après l’intervention est uniquement attribuable à celle-ci. Ces modèles d’étude donnent lieu à des estimations non biaisées de la causalité présentant les niveaux les plus élevés de validité interne. Essais contrôlés randomisés

(ECR)/Expérimentation2 L’intervention est menée de façon aléatoire ou une variation indépendante dans l’intervention peut être isolée après l’application des méthodes d’estimation respectives. Toutefois, certains facteurs de confusion liés à l’administration de l’intervention (comme des effets placebo ou des effets découlant du fait d’être observé) pourraient biaiser l’estimation des effets du traitement. Des preuves convaincantes ont été présentées pour appuyer l’argument selon lequel les hypothèses émises à l’aide de la méthode d’estimation sont valables. Introduction par étapes

Estimation à l’aide de variables instrumentales (VI)

Modèle de discontinuité de la régression3 L’intervention n’est pas menée de façon aléatoire. La méthode d’estimation permet de contrôler les biais de sélection découlant de facteurs de confusion observables et au minimum quelques-uns des biais découlant de facteurs de confusion non observables. Des preuves raisonnables ont été présentées pour appuyer l’argument selon lequel les hypothèses émises à l’aide de la méthode d’estimation sont susceptibles d’être valables. Nous ne pouvons pas conclure avec certitude qu’il y a un effet de causalité. Toutefois, les méthodes de niveaux 2, 3 et 4 se sont révélées efficaces (Concato, Shah, & Howritz, 2000) et constituent la forme d’évaluation dominante pour l’analyse des politiques. Écart entre les différences

Interruption du traitement et variables dépendantes non équivalentes4 L’intervention n’est pas menée de façon aléatoire. La méthode d’estimation permet de contrôler les biais de sélection découlant de facteurs de confusion observables, mais pas les biais découlant de facteurs de confusion non observables. Il y a de fortes chances que les hypothèses émises à l’aide de la méthode d’estimation ne sont pas valables. Nous ne pouvons donc pas conclure avec certitude qu’il y a un effet de causalité. Toutefois, les méthodes de niveaux 2, 3 et 4 se sont révélées efficaces et constituent la forme d’évaluation dominante pour l’analyse des politiques. Appariement

Études cas-témoins5 L’intervention n’est pas menée de façon aléatoire, mais les données sont connues pour le groupe traité et le groupe non traité. Les méthodes d’estimation ne sont pas à l’origine du biais de sélection. Au mieux, ces méthodes peuvent montrer une corrélation entre l’intervention et les résultats, mais la corrélation n’est pas la causalité étant donné qu’elle pourrait être attribuable à une multitude d’autres raisons : les résultats pourraient être à l’origine de la participation à l’intervention (causalité inverse); les résultats pourraient être attribuables à la situation et aux caractéristiques particulières du groupe traité (biais de sélection et régression vers la moyenne); les résultats pourraient être attribuables à un certain nombre d’autres événements (effets historiques). Ces méthodes présentent des niveaux minimaux de validité interne et seront généralement extrêmement biaisées. Le biais sera généralement ascendant, c’est-à-dire que les évaluations des impacts fondées sur ces modèles d’étude surestimeront systématiquement les impacts de l’intervention. Par conséquent, ces méthodes ne devraient pas être utilisées pour mesurer les impacts , mais plutôt pour formuler des hypothèses et fournir des preuves appuyant les études de rang plus élevé dépassant le seuil de validité de niveau 4. Écart dans les moyennes

Estimation avant-après

Analyse comparative à l’aide de données agrégées6 Aucun groupe de comparaison (groupe témoin ou groupe de traitement avant la réception du traitement) ne permet de comparer les observations relatives au traitement. Parallèlement, les conclusions de l’étude ne sont pas fondées sur des données individuelles, mais plutôt sur des arguments théoriques ou des opinions subjectives qui ne sont pas appuyés par des preuves et qui ne tiennent pas compte des éventuelles menaces touchant la validité. Ces méthodes ne devraient pas être utilisées pour mesurer les impacts en soi, mais plutôt pour formuler des hypothèses et fournir des preuves appuyant les études de rang plus élevé. Énoncés de lien de causalité non appuyés par des données ou d’autres études Mises en garde et avertissements

- La classification de l’Échelle des preuves d'Impact Canada se fonde uniquement sur la validité interne des méthodes et ne tient pas compte de la généralisabilité des résultats (validité externe).

- L’échelle s’applique aux évaluations individuelles. Certaines échelles de preuves dans le domaine des sciences médicales comportent des niveaux plus rigoureux selon que les résultats ont été ou non reproduits dans des études de suivi. La reproduction des résultats est alors utilisée pour renforcer les conclusions d’une étude.

- Le contexte dans lequel l’étude a été réalisée est également important. Le contexte peut suggérer que certaines hypothèses ne sont pas valables ou que le budget, les ressources et les conditions initiales ne conviennent pas à une méthodologie donnée. Si les hypothèses ne sont pas confirmées ou que la méthodologie ne peut pas être adéquatement appliquée, les méthodes plus élevées dans le classement ne se révéleront alors pas plus efficaces que toute autre méthode de l’échelle. Étant donné que le contexte dans lequel l’étude est réalisée est important, les échelles de preuves comme celle décrite ci-dessus devraient être vues comme des guides pour évaluer la validité des différentes méthodes plutôt que comme une règle absolue.

5.0 Méthodes d’estimation des impacts

Les sections suivantes fournissent un aperçu des principales méthodes de mesure des impacts. Elles décrivent ces méthodes en détail et les structurent en ordre de rigueur décroissant en fonction de leur capacité à cerner adéquatement les résultats contrefactuels. L’ordre de présentation des méthodes dans une même sous-section est arbitraire. Un bref aperçu de ces méthodes, ainsi que de leurs avantages et désavantages, est fourni dans une annexe à titre de référence. Une section subséquente aborde le rôle complémentaire important que jouent les méthodes qualitatives dans la mesure des impacts.

5.1 L’essai contrôlé randomisé et l’approche expérimentale

L’expérimentation (un terme souvent utilisé de façon interchangeable avec le terme « essai contrôlé randomisé ») est la meilleure façon de respecter le principe ceteris paribus. Lorsqu’elles sont bien exécutées, les expérimentations sont les méthodes qui comportent le plus haut niveau de validité interne, ce qui signifie qu’elles constituent d’excellentes méthodes de mesure des impacts là où elles s’appliquent.

La caractéristique clé des expérimentations est la répartition aléatoire dans le groupe de traitement et le groupe témoin. La répartition aléatoire dans les deux groupes signifie que chaque individu est associé à un groupe uniquement par hasard. Cette méthode comporte deux grands avantages :

- Elle permet de s’assurer que les deux groupes sont équilibrés (au chapitre des attentes) en ce qui a trait aux éléments observables et aux éléments non observables. Les deux groupes seront aussi semblables que possible. Étant donné que les deux groupes ne sont pas intrinsèquement différents, aucun élément n’est susceptible d’exercer une influence différente sur les résultats.

- Cela assure également que toute menace touchant la validité est répartie de façon aléatoire entre les deux groupes. Ainsi, tous les autres facteurs susceptibles de modifier les résultats sont eux aussi équilibrés entre les deux groupes, donc ces effets « s’annulent ». Par conséquent, toute variation observée dans les résultats peut être directement attribuée au programme, à l’exclusion de tout autre facteur.2

Version texte - Figure 4

Un organigramme illustre la logique de base de l’essai contrôlé aléatoire. L’assignation aléatoire est représentée par un rectangle foncé, qui crée deux groupes : un groupe d’essai (représenté par un rectangle moyennement ombragé) et un groupe témoin (représenté par un rectangle légèrement ombragé). Le groupe d’essai passe par une ligne continue à travers une mesure de référence (représentée par un rectangle moyennement ombragé), une intervention (représentée par un losange) et, finalement, une mesure des résultats (représentée par un rectangle). Le groupe témoin traverse une ligne continue allant directement d’une mesure de référence à une mesure des résultats, les deux étant représentées par des rectangles légèrement ombragés. C’est pourquoi la comparaison des résultats des groupes d’essai et de contrôle nous permet de déterminer l’effet d’une intervention : la seule différence entre les deux groupes est l’exposition à l’intervention.

Cela signifie que la répartition aléatoire est une façon extrêmement efficace d’écarter d’autres explications pour les résultats changeants. Avec la répartition aléatoire, tout changement dans les résultats observés dans les deux groupes ne peut pas être attribué aux écarts entre les deux groupes étant donné qu’il n’y a pas d’écarts, ni à d’autres causes étant donné que toute cause existante a un effet équivalent sur les résultats des deux groupes.

L’autre caractéristique clé de l’expérimentation réside dans les « mesures de contrôle ». Nous pouvons considérer les mesures de contrôle comme des caractéristiques qui préservent les avantages de la répartition aléatoire. Contrôler une étude signifie préserver la composition du groupe test et du groupe témoin pour éviter qu’elle change au fil du temps. Cela signifie habituellement :

- S’assurer qu’il n’y a pas d’attrition dans les groupes. Nous savons que l’attrition (abandon) n’est généralement pas aléatoire, et qu’il est donc très possible que l’étude commence avec des groupes répartis de façon aléatoire, mais se termine avec des groupes qui ne sont plus comparables en raison de l’attrition;

- S’assurer qu’il n’y a pas de contamination, c’est-à-dire que tous les participants du groupe test sont effectivement exposés au programme/au traitement/à l’intervention et qu’aucun participant du groupe témoin n’y est exposé;

- Protéger les groupes des effets comportementaux. Comme il est indiqué précédemment, les sujets d’études contrôlées peuvent modifier leur comportement lorsqu’ils sont conscients qu’ils sont exposés à un traitement. De façon similaire, les administrateurs du programme ou encore les individus qui évaluent les impacts pourraient se comporter différemment envers le groupe test et envers le groupe témoin. Ces « changements » de comportement ont souvent une influence sur les résultats qui nous intéressent, ce qui signifie que tout changement observé dans les résultats ne peut pas être entièrement attribué au programme lui-même. Les meilleures évaluations des impacts sont menées à l’insu de tous, ce qui signifie qu’aucune des personnes en cause (participants, administrateurs du programme, évaluateurs, etc.) ne peut distinguer le groupe de traitement du groupe témoin. En pratique, il est difficile de mener des évaluations des impacts à l’insu de tous (voir l’explication ci-dessus).

Il faut savoir que les expérimentations sont bien plus que de simples évaluations randomisées – d’autres caractéristiques sont nécessaires pour préserver le modèle de répartition aléatoire tout au long du processus d’évaluation des impacts. Nous devons être conscients qu’une expérimentation qui s’accompagne de mesures de contrôle inadéquates pourrait ne pas respecter le principe ceteris paribus, et que les résultats de telles évaluations des impacts devraien être interprétés avec prudence.

5.2 Variantes des ECR

L’approche traditionnelle associée aux ECR consiste à répartir simultanément et aléatoirement les participants dans le groupe de traitement et le groupe témoin, et à mesurer les résultats après le traitement. Toutefois, cela n’est pas toujours possible et dans ces cas, il y a des façons d’utiliser la répartition aléatoire de façon créative pour obtenir à peu près le même effet. L’introduction par étapes, les essais à volets multiples et les plans factoriels sont quelques-unes des approches couramment utilisées dans les modèles de répartition aléatoire pour l’évaluation pragmatique des résultats. Ces différentes variantes du modèle d’ ECR classique peuvent être attrayantes puisqu’elles peuvent très bien s’intégrer dans les modes d’opération naturelle de nombreux programmes et dans de nombreux contextes de prestation de services.

Introduction par étapes

Aussi appelé essai par étapes, liste d’attente ou comparaison de pipeline, ce modèle est une adaptation de l’ ECR , où une intervention est déployée en deux étapes ou plus auprès des participants, et où les participants sont répartis de façon aléatoire dans les différentes phases. Cette approche peut s’appliquer dans le cadre de programmes à court terme, dont les résultats sont observables peu de temps après la fin de l’intervention. Cette méthode est souvent employée lorsqu’il y a des objections éthiques à refuser le traitement à certains participants étant donné qu’au bout du compte, tous les participants se seront vu offrir le traitement.

La principale caractéristique de ce modèle est que le groupe témoin reçoit l’intervention après le groupe de traitement, plutôt que de ne pas le recevoir du tout. Il est donc possible d’identifier les effets sur le groupe de traitement en le comparant au groupe témoin avant que celui-ci reçoive l’intervention, ou simplement en observant les effets découlant du fait qu’un des groupes a été exposé au traitement plus longtemps que l’autre (pour les interventions à plus long terme). La répartition dans les phases plus précoces ou plus tardives du traitement doit tout de même demeurer aléatoire, c’est-à-dire indépendante de toute caractéristique individuelle, pour que l’étude soit efficace et mène à des estimations présentant un haut degré de validité interne.

Version texte - Figure 5

Un organigramme illustre la logique de base de l’introduction progressive. L’assignation aléatoire à des phases (représentées par un rectangle foncé) crée deux groupes. Le premier groupe est représenté sous la forme d’un rectangle moyennement ombragé, et il passe par une mesure de référence, une intervention et deux mesures des résultats par une ligne continue. Les mesures de référence et les mesures des résultats sont représentées sous forme de rectangles moyennement ombragés et l’intervention sous forme de losange. Le deuxième groupe est représenté sous la forme d’un rectangle ombragé clair et passe par une mesure de référence, une mesure des résultats, une intervention et une deuxième mesure des résultats par une ligne continue. Les mesures de référence et les mesures des résultats sont représentées sous forme de rectangles légèrement ombragés et l’intervention sous forme de losange. Les résultats du premier groupe sont comparés à ceux du deuxième groupe avant l’intervention afin de déterminer l’effet de l’intervention.

Modèles à volets multiples et plans factoriels

Les ECR à volets multiples testent simultanément plusieurs options d’un programme. Dans ce modèle, les participants sont répartis de façon aléatoire dans un programme parmi plusieurs autres, ce qui permet de comparer les résultats des différentes options visées par l’essai. Plus particulièrement, il est possible d’utiliser un ECR à volets multiples qui ne comprend pas de groupe témoin, mais qui compare plutôt les résultats de différents programmes. Ce modèle peut également être utile dans les cas où il est impossible de refuser des traitements aux participants admissibles. Parallèlement, lorsqu’on hésite à former un véritable groupe témoin (aucun programme), on peut intégrer un « volet » dans lequel les participants bénéficient d’une intervention du programme à un degré minime, qui peut ensuite être utilisée dans l’analyse pour estimer les résultats qu’auraient obtenus les participants s’ils n’avaient pas participé au programme.

Version texte - Figure 6

Un organigramme illustre la logique de base des conceptions à plusieurs branches et multifactorielles. L’assignation aléatoire, représentée par un rectangle foncé, crée quatre groupes. Les trois premiers groupes sont représentés par des rectangles moyennement ombragés, et chacun passe par une mesure de référence, l’une des trois interventions et une mesure des résultats par un trait plein. Les mesures de référence et les mesures des résultats sont représentées sous forme de rectangles moyennement ombragés, et les interventions sous forme de losanges. Le quatrième groupe représente le groupe témoin et est représenté sous la forme d’un rectangle légèrement ombragé, qui traverse une mesure de référence et une mesure des résultats, les deux étant également représentés sous la forme de rectangles légèrement ombragés. Les états des résultats des divers groupes peuvent être comparés pour déterminer leurs effets les uns par rapport aux autres ou par rapport au groupe témoin.

-

Quand peut-on utiliser les méthodes randomisées?

Les méthodes dans cette catégorie se caractérisent par le fait que l’administrateur/l’évaluateur du programme peut déterminer à l’avance la répartition des participants au programme/à l’intervention. Ces méthodes pourraient s’appliquer dans les circonstances suivantes :

- Les programmes sont extrêmement populaires. Lorsque le nombre de participants admissibles dépasse le nombre de places offertes dans le cadre du programme, l’approche la plus juste ou la plus éthique est fort probablement la sélection aléatoire.

- Le programme est offert en phases ou en cohortes. Ce type de programme permet l’utilisation de modèles « par étapes », et les participants peuvent être répartis de façon aléatoire dans les différentes phases.

- Lorsqu’un programme est « ajusté » ou que des variantes d’un programme sont mises à l’essai. Les participants peuvent être répartis dans les différentes versions du programme, ce qui permet d’appliquer des modèles à volets multiples/plans factoriels.

-

Points à considérer

- L'intervention doit être attribuée de façon aléatoire.

- Les participants dovent se conformer au groupe dans lequel ils ont été reepartis aleeatoirement (ils ne doivent pas recevoir l'intervention s'ils ont éte placés dans le groupe témoin, tout comme ils doivent la recevoir s'ils sont dans le groupe de traitement).

- L'évaluateur doit s'assurer que l'estimation des impacts n'est pas liée au simple fait que les participants savent qu'ils sont observés ou qu'ils savent a quel groupe ils appartiennent (groupe de traitement ou groupe témoin).

5.3 Approches quasi expérimentales

Il arrive souvent que les administrateurs des programmes ne peuvent pas, ou ne veulent pas, utiliser un modèle de répartition aléatoire, ce qui rend le modèle expérimental impossible à appliquer. Dans ces cas, il y a des façons d’estimer les résultats contrefactuels en procédant à des quasi-expériences. Les quasi-expériences sont définies comme des modèles « caractérisés par une répartition non aléatoire » (Dunning, 2013, p. 19), mais qui tentent de reproduire un grand nombre des avantages de l’ ECR . La caractéristique clé des approches quasi expérimentales est, par conséquent, qu’elles ne permettent pas de déterminer la répartition dans le cadre du programme ou de l’intervention.

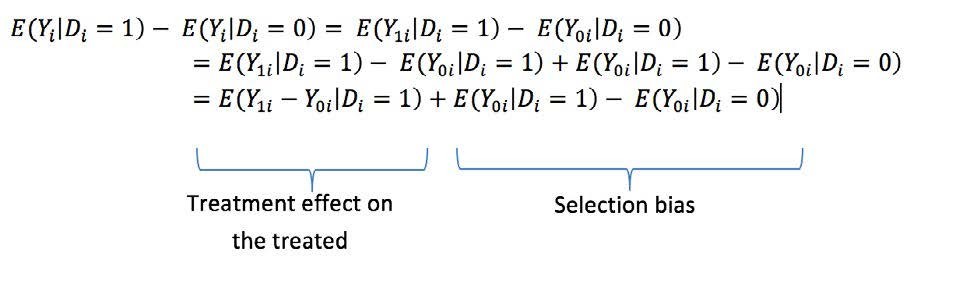

« Les approches quasi expérimentales se définissent comme des modèles « caractérisés par une répartition non aléatoire. »